COSO, ERM i ryzyko „sztucznej inteligencji”

Pożądane nowe kompetencje w zakresie zarządzania ryzykiem

- Projektowanie i wykorzystywanie nowych technologii niesie zarówno szanse jak i zagrożenia. A to powoduje, że nadchodzi czas specjalistów potrafiących prognozować, rozpoznawać, analizować i oceniać ryzyko związane z projektowaniem i wykorzystaniem systemów „sztucznej inteligencji”.

Książek, artykułów i innych publikacji poświęconych tzw. „sztucznej inteligencji” pojawiło się w ostatnich latach dość sporo i można się spodziewać, że będzie ich coraz więcej. Nas interesują – z oczywistych powodów – te publikacje, które odnoszą się do zarządzania ryzykiem; w tym przypadku zarządzania ryzykiem związanym z zastosowaniami technologii „sztucznej inteligencji”.

W roku 2017 w raporcie World Economic Forum (Global Risk Report) przedstawiono wyniki badań ankietowych – przeprowadzonych pod koniec roku 2016 – w których „sztuczną inteligencję” oceniono jako jedną z 5 nowych technologii o potencjalnie największych korzyściach ale jednocześnie jako tę niosącą zdecydowanie największe potencjalne negatywne konsekwencje spośród innych dziedzin nowych technologii.

Sprawa jest więc ważka.

Dosłownie kilka dni temu Committee of Sponsoring Organizations of the Treadway Commission (COSO) zamieścił na swoich stronach nową publikację poświęconą zarządzaniu ryzykiem – tym razem związanym z tzw. „sztuczną inteligencją”: Realize the Full Potencial of Artificial Intelligence.

Podtytuł owej publikacji brzmi: Applying the COSO Framework and Principles to Help Implement and Scale Artificial Intelligence.

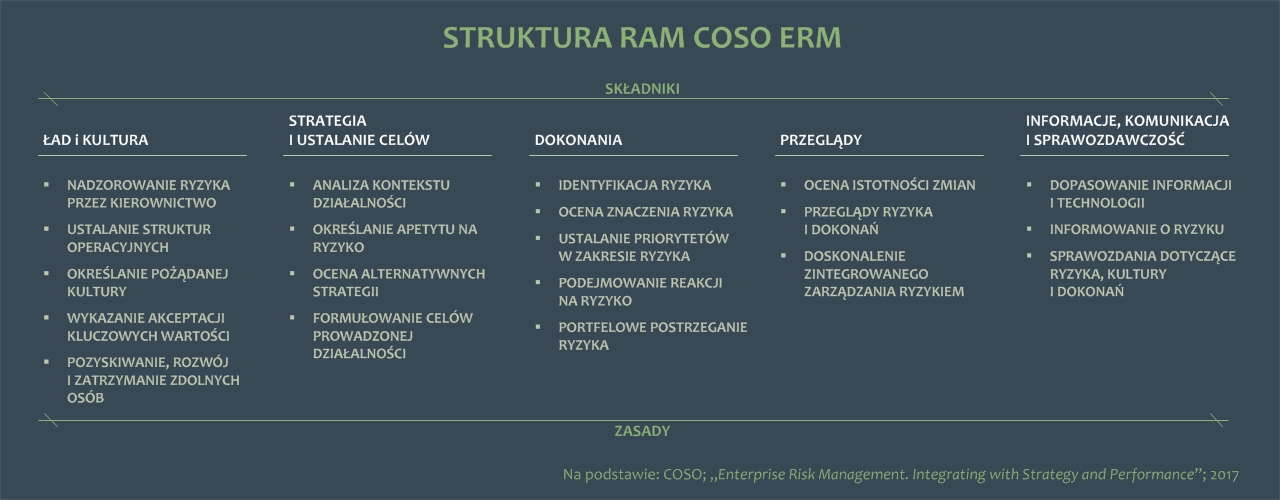

Wprawdzie w tytule ani w podtytule nie występuje słowo „ryzyko” to jednak skoro publikacja przywołuje COSO Framework to mamy i zarządzanie ryzykiem. Przypomnijmy, COSO Framework to sztandarowa publikacja definiująca ramy zintegrowanego zarządzania ryzykiem (Enterprise Risk Management – ERM) w organizacjach.

Dla przypomnienia grafika przedstawiająca strukturę ramową COSO ERM.

Publikacja nie jest obszerna: zagadnienie opisano na zaledwie 22 stronach, co dla niektórych będzie zaletą. Ogólnie rzecz ujmując dokument stanowi próbę dopasowania (powiązania) cyklu życia „sztucznej inteligencji” do cyklu życia (faz i procesów) zintegrowanego zarządzania ryzykiem w organizacjach. Wprawdzie COSO ERM używa pojęcia „składniki” ale to są de facto fazy (etapy) zarządzania ryzykiem. Podobnie „zasady” można traktować jako główne procesy.

Co ciekawe, omawiana publikacja w ogóle nie zawiera formalnej definicji „sztucznej inteligencji”. Autorzy jedynie dość ogólnie wspomnieli co mają na myśli pod pojęciem „sztucznej inteligencji”.

Sięgnijmy zatem do standardów ISO. Możemy tam znaleźć wiele definicji „sztucznej inteligencji” różniących się mniej lub bardziej. A oto ta, zapisana w publikacji oznaczonej i zatytułowanej ISO/IEC 2382:2015 Information technology — Vocabulary:

interdisciplinary field, usually regarded as a branch of computer science, dealing with models and systems for the performance of functions generally associated with human intelligence, such as reasoning and learning

czyli

dziedzina interdyscyplinarna, zwykle uważana za gałąź informatyki, zajmująca się modelami i systemami przeznaczonymi do realizowania funkcji ogólnie związanych z ludzką inteligencją, takich jak rozumowanie i uczenie się

Natomiast w standardzie ISO/IEC TR 24028:2020 Information technology — Artificial intelligence — Overview of trustworthiness in artificial intelligence zapisano (o “sztucznej inteligencji”) tak:

capability of an engineered system to acquire, process and apply knowledge and skills

czyli

zdolność zaprojektowanego systemu do pozyskiwania, przetwarzania i stosowania wiedzy oraz umiejętności

Jakby nie patrzeć, „sztuczna inteligencja” to dziedzina ściśle związana z informatyką wykorzystującą zaawansowane metody ze świata nauk ścisłych.

W publikacji COSO nie znajdziemy tego, co jest istotne z punktu widzenia zarządzania ryzykiem: taksonomii potencjalnych przyczyn, zdarzeń oraz (negatywnych jak i pozytywnych) konsekwencji związanych z wykorzystaniem „sztucznej inteligencji”. Może dlatego, że publikacje COSO nie zawierają w sobie i nie opisują gotowych, szczegółowych i uniwersalnych mechanizmów zarządzania ryzykiem; te trzeba opracowywać uwzględniając charakter organizacji.

Ciekawostką jest również to, że autorzy nadal używają pojęcia „trzy linie obrony” mimo, że IIA (Instytut Audytorów Wewnętrznych) już jakiś czas temu zmienił podejście usuwając z tego hasła wyraz „obrony”. Cóż, siła przyzwyczajenia jest wielka…

Publikacja ta jest przeznaczona przede wszystkim dla członków kierownictw organizacji. Osoby bezpośrednio odpowiadające za zarządzanie ryzykiem technologii informatycznych (a więc i sztucznej inteligencji) muszą poszukiwać innych – bardziej szczegółowych źródeł wiedzy. Z drugiej strony, CRO powinien wiedzieć co kierownictwo organizacji wie (lub powinno wiedzieć) na temat zarządzania ryzykiem – tu związanym ze „sztuczną inteligencją”.

Ale to nie wszystkie istotne publikacje związane z ryzykiem zastosowań „sztucznej inteligencji”.

W połowie tego roku amerykański instytut NIST (National Institute of Standards and Technology) opublikował RFI (Request For Information) – dokument stanowiący zaproszenie do konsultacji w sprawie opracowania podręcznika zawierającego ramy zarządzania ryzykiem sztucznej Inteligencji: Artificial Intelligence Risk Management Framework. Właśnie minął (15 września) termin zgłaszania uwag i propozycji. Nie wiemy, ile podmiotów złożyło swoje propozycje ale na stronach internetowych NIST można zapoznać się z niektórymi (być może są to wszystkie) nadesłanymi uwagami. NIST informuje, że pierwszej wersji publikacji można spodziewać się pod koniec przyszłego roku.

Tymczasem w ISO (International Organization for Standardization) od 2 lat trwają prace nad standardem aktualnie oznaczonym ISO/IEC AWI 23894 Information Technology — Artificial Intelligence — Risk Management. Standard ma zostać opublikowany we wrześniu 2022 roku.

Tak więc pod koniec przyszłego roku zainteresowane firmy i instytucje będą miały w dyspozycji 3 dokumenty o charakterze wytycznych dotyczących zarządzania ryzykiem sztucznej inteligencji:

- Publikacja COSO

- Standard ISO

- Publikacja (Framework) NIST.

W naszych przewidywaniach – opartych na dotychczasowych publikacjach COSO, ISO i NIST – najbardziej konkretną będzie opracowanie przygotowywane przez NIST.

Ale nadal to nie wszystko.

Trzeba pamiętać, że w strukturach Unii Europejskiej trwają prace nad przepisami dotyczącymi „sztucznej inteligencji”. W kwietniu tego roku opublikowano wniosek (i projekt rozporządzenia) dotyczący ustanowienia Aktu w sprawie sztucznej inteligencji – Artificial Intelligence Act (AIA). Projekt rozporządzenia nie zawiera definicji „sztucznej inteligencji” natomiast wprowadza i definiuje „system sztucznej inteligencji”:

oprogramowanie opracowane przy użyciu co najmniej jednej spośród technik i podejść wymienionych w załączniku I, które może – dla danego zestawu celów określonych przez człowieka – generować wyniki, takie jak treści, przewidywania, zalecenia lub decyzje wpływające na środowiska, z którymi wchodzi w interakcję

Wspomniany w definicji załącznik I zawiera następujące zestawienie „technik i podejść z zakresu sztucznej inteligencji”:

- a) mechanizmy uczenia maszynowego, w tym uczenie nadzorowane, uczenie się maszyn bez nadzoru i uczenie przez wzmacnianie, z wykorzystaniem szerokiej gamy metod, w tym uczenia głębokiego;

- b) metody oparte na logice i wiedzy, w tym reprezentacja wiedzy, indukcyjne programowanie (logiczne), bazy wiedzy, silniki inferencyjne i dedukcyjne, rozumowanie (symboliczne) i systemy ekspertowe;

- c) podejścia statystyczne, estymacja bayesowska, metody wyszukiwania i optymalizacji.

Wszystko jasne?

:))

Ponieważ „sztuczna inteligencja” a właściwie systemy „sztucznej inteligencji” niewątpliwie będą odgrywać coraz większą rolę we wszystkich dziedzinach życia gospodarczego i społecznego w związku z tym będą potrzebni specjaliści potrafiący prognozować, rozpoznawać, analizować i oceniać ryzyko związane z projektowaniem i wykorzystaniem systemów „sztucznej inteligencji”. Nietrudno się domyślić, że pożądani będą specjaliści od ryzyka systemów AI posiadający interdyscyplinarne wykształcenie (wiedzę) i umiejętności.

Co tu dużo pisać, szykują się nowe ścieżki kariery w dziedzinie zarządzania ryzykiem.