Ryzyko sztucznej inteligencji: NIST versus ISO

Nowe publikacje dotyczące ryzyka sztucznej inteligencji

- Sztuczna inteligencja (Artifficial Intelligence – AI) w najbliższych latach stanowić będzie potężne wyzwanie dla osób zajmujących się zarządzaniem ryzykiem w organizacjach – nie tylko w podmiotach z rynku finansowego ale również w przemyśle, sektorze zdrowia, IT a także w administracji publicznej.

„Sztuczna Inteligencja” – temat ten w ostatnich latach wykroczył poza ramy laboratoriów i instytucji naukowych. Coraz więcej osób spotyka się na co dzień ze zjawiskami (produktami, usługami) z zakresu sztucznej inteligencji. Dość wspomnieć o tzw. autonomicznych samochodach, robotach specjalistycznego zastosowania czy też … aplikacji zdolnej tworzyć publikacje na zadany temat.

Czymże jest owa sztuczna inteligencja?

ISO zawarło definicję sztucznej inteligencji w standardzie ISO/IEC 22989:2022 Information technology — Artificial intelligence — Artificial intelligence concepts and terminology. Brzmi ona tak:

Dyscyplina zajmująca się badaniem i rozwojem mechanizmów i zastosowań systemów AI

Nota 1: Badania i rozwój mogą odbywać się w dowolnej liczbie dziedzin, takich jak informatyka, nauka o danych, nauki humanistyczne, matematyka i nauki przyrodnicze.

Z kolei publikacje NIST opierają się o definicję sztucznej inteligencji zapisanej w ANSI INCITS 172-2002 (R2007) Information Technology—American National Standard Dictionary of Information Technology (ANSDIT)

Gałąź informatyki zajmująca się opracowywaniem systemów przetwarzania danych, które wykonują funkcje zwykle związane z ludzką inteligencją, takie jak rozumowanie, uczenie się i samodoskonalenie.

Zdolność urządzenia do wykonywania funkcji normalnie związanych z ludzką inteligencją, takich jak rozumowanie, uczenie się i samodoskonalenie.

Sprawa zaczyna być poważna, również w Polsce. Kilka lat temu, w grudniu 2018 roku Rada Ministrów przyjęła uchwałę dotyczącą rozwoju sztucznej inteligencji w Polsce. Integralną częścią tej uchwały jest „Polityka dla rozwoju sztucznej inteligencji w Polsce od roku 2020”. W założeniach tej polityki oparto się na definicji pochodzącej z z publikacji OECD (z roku 2019) zatytułowanej: Scoping the OECD AI principles deliberations of the expert group on Artificial Intelligence at the OECD (AIGO):

System sztucznej inteligencji to system oparty na maszynie, który jest w stanie wpływać na środowisko poprzez wydawanie zaleceń, prognoz lub decyzji dotyczących danego zestawu celów. Czyni to poprzez wykorzystanie danych pochodzących od maszyn i/lub ludzi w celu:

i) postrzegania rzeczywistych i/lub wirtualnych środowisk;

ii) formułowania (ręcznie lub automatycznie) takiego postrzegania w postaci modeli; oraz

iii) wykorzystywania interpretacji modeli do formułowania wariantów wyników.

Jednym słowem, sztuczna inteligencja to urządzenia wyposażone w oprogramowanie mające specjalne funkcje – wykraczające poza właściwości (funkcje) dotychczas powszechnie znanych programów i systemów komputerowych.

Sprawa jest poważna, albowiem ze sztuczną inteligencją wiążą się ogromne możliwości i szanse rozwoju ludzkości w aspekcie technicznym, społecznym, ekonomicznym, prawnym i politycznym. Ale sztuczna inteligencja to nie tylko szanse ale i zagrożenia. A skoro tak, to mamy do czynienia z ryzykiem sztucznej inteligencji.

Na początku lutego bieżącego roku nastąpiła swoista kumulacja – dwie organizacje udostępniły pierwsze wersje swoich publikacji odnoszących się do zarządzania ryzykiem związanym ze sztuczną inteligencją.

Pierwsza publikacja jest sygnowana jest przez amerykański National Institute of Standards and Technology (NIST) oraz U.S. Department of Commerce: NIST AI 100-1: Artificial Intelligence Risk Management Framework (AI RMF 1.0)

Drugą publikacją jest standard wydany przez International Organization for Standardization: ISO/IEC 23894-2023 Information technology — Artificial intelligence — Guidance on risk management

Cykl życia obu dokumentów jest bardzo podobny – mniej więcej rok temu oba dokumenty zostały przygotowane i opublikowane w wersji roboczej.

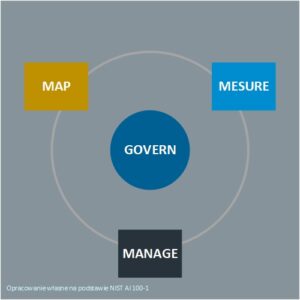

AI RMF – Artificial Intelligence Risk Management Framework

Ogólna struktura dokumentu (Ram zarządzania ryzykiem sztucznej inteligencji) jest oparta na 4 funkcjach: Nadzór (govern), Plan (map), Pomiar (measure) oraz Sterowanie (manage).

Ogólna struktura dokumentu (Ram zarządzania ryzykiem sztucznej inteligencji) jest oparta na 4 funkcjach: Nadzór (govern), Plan (map), Pomiar (measure) oraz Sterowanie (manage).

Nadzór – ustalenie zasad, mechanizmów i struktur zarządzania ryzykiem systemów sztucznej inteligencji

Plan – rozpoznanie i ustalenie kontekstu, środowiska, celów i zakresu systemów AI oraz struktury ryzyka (zagrożeń i/lub szans)

Pomiar – analiza, ocena oraz monitorowanie ryzyka

Sterowanie – reagowanie na ryzyko oraz monitorowanie i doskonalenie mechanizmów zarządzania ryzykiem

Funkcje te podzielone są na kategorie (pożądane stany / dokonania), którym przypisano szczegółowe zasady a tym z kolei przypisano zalecane działania.

Dokument liczy 48 stron. Niby niewiele, ale publikacji tej towarzyszy Podręcznik (tzw. Playbook) – internetowe repozytorium dokumentów stanowiących rozszerzenie i zapisów Ram Zarządzania Ryzykiem Sztucznej Inteligencji w odniesieniu do poszczególnych funkcji:

- NIST AI Risk Management Framework Playbook – GOVERN (26 stron)

- NIST AI Risk Management Framework Playbook – MAP (27 stron)

- NIST AI Risk Management Framework Playbook – MANAGE (19 stron)

- NIST AI Risk Management Framework Playbook – MESURE (36 stron)

Ogromną zaletą tych dokumentów jest to, że zawierają niezwykle bogatą listą przypisów stanowiących jednocześnie odnośniki (łącza) internetowe. Dzięki temu, osoby nie posiadające wiedzy z zakresu sztucznej inteligencji mogą skorzystać z licznych publikacji odnoszących się do tego zagadnienia.

Uzupełnieniem jest również ogólna taksonomia ryzyka sztucznej inteligencji – póki co w wersji roboczej, z roku 2021.

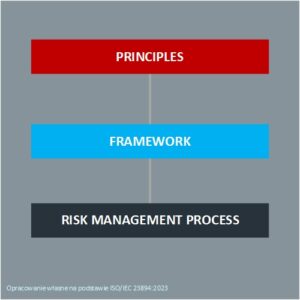

ISO/IEC 23894 Information technology — Artificial intelligence — Guidance on risk management

To, co od razu rzuca się w oczy to to, że ogólna struktura dokumentu jest bardzo podobna do struktury standardu ISO 31000-2018: Risk management — Guidelines. Wskazuje na Zasady (principles), określa Ramy (framework) oraz definiuje działania w ramach procesu zarządzania ryzykiem (risk management process).

To, co od razu rzuca się w oczy to to, że ogólna struktura dokumentu jest bardzo podobna do struktury standardu ISO 31000-2018: Risk management — Guidelines. Wskazuje na Zasady (principles), określa Ramy (framework) oraz definiuje działania w ramach procesu zarządzania ryzykiem (risk management process).

Dokument liczy zaledwie 26 stron. Bibliografia liczy „aż” 9 pozycji z tego tylko jedna pochodzi spoza publikacji (standardów) ISO.

Trzeba dodać, że organizacja ISO opublikowała dotychczas 17 standardów dotyczących AI a w opracowaniu – na różnych etapach– znajduje się aż 25 pozycji poświęconych głównie technicznym aspektom projektowania, wdrażania i użytkowania sztucznej inteligencji.

Pełna taksonomia ryzyka (zagrożeń i/lub szans (możliwości, korzyści) a także metody rozpoznawania, analizy i oceny ryzyka zależne są od konkretnej dziedziny zastosowań sztucznej inteligencji. Inaczej to będzie w medycynie, inaczej w transporcie a jeszcze inaczej w administracji publicznej. Siłą rzeczy oba dokumenty mają charakter ogólny – bez odniesień do konkretnych zastosowań.

Ale jedno możemy napisać, jeżeli ktoś chce analizować ryzyko sztucznej inteligencji z perspektywy ogólnego zarządzania organizacjami (podejście menedżerskie) to powinien raczej wybrać publikację NIST. Osoby zaangażowane bezpośrednio w projektowanie, tworzenie i wdrażanie produktów sztucznej inteligencji nie mają wyboru: oprócz publikacji NIST powinny mieć na uwadze standardy ISO – nie tylko ten dotyczący zarządzania ryzykiem sztucznej inteligencji.

No i coś, co dla wielu będzie czynnikiem decydującym – przynajmniej na początku: standard ISO/IEC 23894 kosztuje 124 CHF natomiast publikacje NIST można pobrać bezpłatnie.